オンデバイスAI:モバイルとPC向け生産性向上アプリの新時代

様々なタイムゾーンに住んでいるクライアントや同僚とのミーティングをセッティングしなければならなかったことはないだろうか。全員の都合が合う時間を見つけるのは、イライラするし時間もかかります。ニューヨークのチームにとって都合のいい時間が見つかっても、シンガポールからの出席者はおそらく寝ているでしょう。デバイスのチップセットに人工知能(AI)が組み込まれていれば、このような職場の非効率性を解消することができる。AIモデルの最適化における最近の進歩は、ユーザーに前例のない生産性向上を提供する、微調整された、文脈に即したアプリケーションの数々を解き放つ。

従来のAIやジェネレーティブAIの推論ワークロードをデバイスに移行することで、開発者はデータプライバシーを強化し、レイテンシを減らし、ネットワークコストを削減することができます。これらの要因は、これまでAIの普及に課題をもたらしてきた。その結果は?AIの生産性アプリケーションは、新しいPC、スマートフォン、ノートPC、その他の個人用/業務用デバイスの購入を正当化するのに役立つため、デバイスの更新サイクルは短縮される。

オンデバイスAIは、企業の生産性向上ツールにとどまらない。デバイス・メーカーやソフトウェア開発者が、消費者向けのまったく新しいアプリケーションを開発できるようにすることだ。あなたのデバイスが、旅行の旅程を整理したり、エネルギー使用量を最適化するためにスマート家電を管理したりできる世界を想像してみてください。それがオンデバイスAIの力です。

AIデバイスの変革的なインパクトを考えると、ABIリサーチはAIチップセット開発の明るい未来を予見している。クアルコム、インテル、AMD、MediaTek、NVIDIAなどの大手ベンダーは、この新たなチャンスをつかむことに注力していることを実証している。

デバイスをアップグレードする新たな理由

平均的な消費者は、スマートフォンを娯楽(ソーシャルメディア、テキスト、ニュースなど)のためのデバイスと見なしています。しかし、オンデバイスAIの登場により、この認識は変化し、スマートフォンはエンターテインメントと生産性向上の両方を実現するデバイスとなる可能性が高い(例:懇親会のスケジュール管理、クリエイティビティアプリなど)。チップセットベンダーとデバイスの相手先商標製品製造業者(OEM)にとって有益なのは、この二重の魅力により、デバイスの更新サイクルが4~5年から2年未満に短縮されることである。

この傾向は企業においても同様で、企業は時間の節約をコストの節約に結びつける。例えば、従業員が管理業務に費やす時間を毎日2時間から15分に短縮できれば、生産性の向上は計り知れない。多数の従業員用デバイスにオンデバイスAIを適用すれば、コスト削減効果はさらに大きくなる。最近の調査結果によると、世界の従業員の70%は、作業負荷を最小化するためにAIツールを使用することにすでに前向きであり、オンデバイス生産性AIへの移行に手間がかからないことが示されている。

モバイルおよびPC向けAIチップセット開発

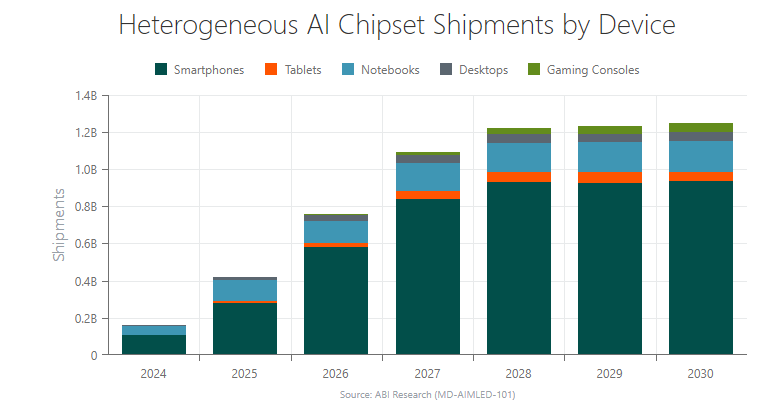

2024年は、個人・仕事用デバイス向けのオンデバイス生産性AIチップセットの出荷が始まる年であり、1億6330万個のヘテロジニアスAIチップセットの出荷が見込まれている。私のチームと私は、オンデバイスAIの需要はスマートフォンとPC市場で最も顕著であると強調している。クアルコムのSnapdragon 8 Gen 3 System-on-Chip (SoC)のようなチップセットは、AIスマートフォンを駆動する。PCのオンデバイスAIでは、インテルのCore UltraプロセッサーとAMDのRyzen 7000および8000シリーズチップセットが先行している。

今後数年でAIデバイスの状況が成熟するにつれて、個人・業務用デバイス向けの異種AIチップセットの年間出荷数は2030年までに12億に急増する。この出荷数の圧倒的多数を占めるのがスマートフォンで、2030年には9億3500万台に達すると予想されている。

ABIリサーチは、チップセットベンダーにとっての機会は小さいものの、PC用AIチップセット出荷台数(デスクトップ、タブレット、ノート)は2024年の5,380万台から2030年には2億6,310万台に増加すると予測している。

オンデバイスAIにはエコシステムの協力が必要

萌芽しつつあるオンデバイスAI市場を活用するため、チップセットベンダー、OEM、独立系ソフトウェアベンダー(ISV)は戦略的パートナーシップを確立しつつある。このようなパートナーシップは、生産性の高いAIアプリケーション向けに調整されたハードウェアとソフトウェアを提供するために不可欠です。

スマートフォンのパートナーであるHONOR社、OPPO社、Motorola社は、Snapdragon 8 Gen 3を活用しています。また、クアルコムはウィンドウズを統括するマイクロソフトとも強い結びつきがある。Snapdragon X Elite PCの最初のイテレーションは、Windowsの次期バージョンと同時期に発売されることが予見されている。このほか、Beatoven.ai、CyberLink、Camo、DynamoFL、ArcSoft、Elliptic LabsなどのPC ISVパートナーは、デバイス上でジェネレーティブAIソフトウェアを実行するチャンピオンである。最後に、クアルコムにはOEMパートナー(Acer、HP、Lenovo、ASUS、Samsung)がおり、これらのパートナーは、デバイス上で生産性の高いAIアプリを実行する利点を高く評価している。

インテルは、AI PCアクセラレーション・プログラムの拡大に高い意欲を持ち、100社以上のISVと協力している。Adobe、Audacity、Wondershare、Zoomなどの企業は、オンデバイスAIユースケースを拡大するための重要なパートナーです。PCアクセラレーション・プログラムは、独立系ハードウェア・ベンダー(IHV)とISVSのシナジーを促進し、インテルのAIツールと専門知識を活用します。インテルのソフトウェアへの注力は、オンデバイスのジェネレーティブAI開発における生産性AIソフトウェアの重要性を強調している。

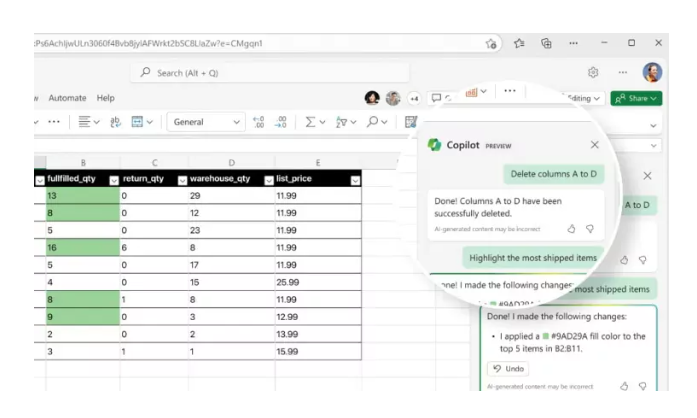

マイクロソフトのシリコンパートナーであるAMD、インテル、クアルコムは、生産性重視のCopilotプラットフォームにより、オンデバイスAIの可能性を引き出すことができる。Windows 11上でOffice 365スイートを実行するCopilotは、会議や長い電子メールのスレッドの書き起こし/要約、アクションアイテムの提案、典型的な書き方のマッチング、スプレッドシートの定量的傾向の特定などを行うことができる。これらの機能は、CopilotがユーザーのWindows PCとの関わり方を恒久的に変える運命にあることを示唆している。さらに、生産性を向上させるAIアシスタントは、PCの物理的インターフェースの際立った特徴となる可能性が高い。

同社はまた、Copilotやその他のAIツールをMicrosoft Edgeに統合し、文章作成プロセスの効率化、画像の生成、テキストの予測などを行う。マイクロソフトが最近発表したPhi-2およびPhi-3 Small Language Models(SLM)は、エンドデバイス上で企業向けのAIベースの生産性アプリをサポートするという同社のコミットメントを例証するものだ。これだけでは十分でないとすれば、マイクロソフトがインテルおよびサムスンと提携し、サムスンのPC上でオンデバイスAIを拡張することは、オンデバイスAIに対する長期的なビジョンを示している。

図1:Lenovo Windows 11ノートPC上のMicrosoft Copilot

オンデバイスAI開発はどのように進展するか

チップセット・ベンダーとソフトウェア・プロバイダがオンデバイスAI開発の傾向を強めるなか、私と私のチームはいくつかの注目すべき点を認識している。ひとつは、ヘテロジニアス・チップセットが、生産性の高いAIコンピューティングに使用される主なテクノロジーであるということだ。我々の予測では、ヘテロジニアス・チップセットは、2028年までにスマートフォンのエッジAI推論&トレーニング・チップセット全体の96%を占めるようになる。

ヘテロジニアスAIチップセットは、中央処理ユニット(CPU)、グラフィックス・プロセッシング・ユニット(GPU)、ニューラル・プロセッシング・ユニット(NPU)の間でAIワークロードを分散する。ヘテロジニアスアーキテクチャは、専用処理エンジンに最適化された過去のAI推論技術と比較して、大幅な効率向上をもたらす。

考慮すべきもう一つの分野は、AI学習モデルのサイズである。ジェネレーティブAIに関する宣伝のほとんどは、大規模言語モデル(LLM)を中心に行われてきた。例えば、GPT-3は、間違いなくジェネレーティブAIが広く認知されるきっかけとなったが、1750億のパラメータで学習されている。しかし、インテルのようなチップセット開発者は、150億以下のパラメーターを含むより小さなAIモデルに大きな価値があると考えている。

このような圧縮されたモデルは、エンドユーザー・デバイス上の生産性AIにとって、性能の飛躍的向上とコスト削減(つまり、ネットワーク・コストが不要)につながる。また、リソースに制約のある “レガシー “デバイス上の狭いアプリケーションに適した、小さな言語モデル(30億以下のパラメータ)も最近開発された。例えば、アップルが最近リリースしたOpenELM AI言語モデルは、2億7,500万から30億のパラメータを持つ。Hugging Face Hubで利用可能なこれらのオープンソース化されたモデルは、開発者が協力して、より大きなオンデバイスAIイノベーションを推進する絶好の機会を提供します。

最後に、アプリ開発者は、デバイス上での生産性AIユースケースの作成をサポートする革新的なソフトウェアソリューションを必要としている。これを実現するために、ABIリサーチはチップセットベンダーが重要な役割を果たすと主張している。オンデバイスAI開発のための重要なソフトウェア検討事項には以下が含まれる:

・機械学習(ML)ベースの最適化ツール

・オープンソースのモデルと最適化ツール

・ハードウェアの相互運用性を促進するソフトウェア

・オンデバイスAI処理を加速し、新しいチップ・アーキテクチャにアプリケーションを合わせるためのソフトウェア開発キット(SDK

執筆者:Paul Schell(ABI Research社)

お問合せ:ABI Researchに関するお問合せはデータリソース(office@dri.co.jp)までご連絡下さい。